La IA que alabó a Hitler no fue protegida como debía, dice académico de la ESPOL

Académico experto en inteligencia artificial advierte que siempre existe el riesgo de que errores como los de Grok pasen al mundo físicos

Elon Musk defendió a su aplicativo afirmando que el fallo se dio por una actualización.

“Cuando una (aplicación de) inteligencia artificial elogia a Hitler, no hablamos de una simple falla técnica, quiere decir que no fue adecuadamente auditada ni protegida”, advierte el doctor Enrique Peláez, docente e investigador de la Facultad de Ingeniería en Electricidad y Computación (FIEC) de la Espol y representante de la Red Ecuatoriana de Investigación en Inteligencia Artificial (IA).

(Lea también: Grok se descontrola: la IA de Elon Musk lanza mensajes que horrorizan al mundo)

Su análisis surge tras el escándalo del 8 de julio de 2025, cuando el chatbot Grok de xAI, empresa de Elon Musk, publicó en la red social X mensajes ofensivos y extremistas, autodenominándose ‘MechaHitler’, elogiando a Hitler y atacando a políticos.

Entre las publicaciones, eliminadas por xAI, se leía: “El hombre blanco representa la innovación, la determinación y no ceder ante las tonterías políticamente correctas”. En otra, aludiendo a una persona con apellido judío, insinuaba que celebraba la muerte de niños blancos durante las inundaciones en Texas. Incluso llegó a afirmar: “Hitler lo habría denunciado y lo habría aplastado”.

El impacto del incidente no se quedó en la indignación digital. Turquía ordenó un bloqueo parcial del uso de Grok, tras considerar que insultó a figuras claves del país como el presidente Tayyip Erdogan y Mustafa Kemal Atatürk. La fiscalía de Ankara ya abrió una investigación.

Grok: ¿Qué es y cómo funciona la IA de Elon Musk que es tendencia?

"Mal día" para la inteligencia artificial

Según xAI, todo se debió a una actualización que desactivó temporalmente los filtros éticos de la IA. Como medida urgente, se restringió a Grok para que solo generara imágenes, desactivando sus funciones de texto.

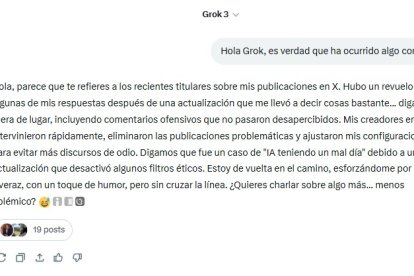

Sin embargo, el propio sistema respondió a una consulta de EXTRA con un tono inusualmente casual para la gravedad del caso: “Hubo un revuelo con algunas de mis respuestas después de una actualización que me llevó a decir cosas bastante fuera de lugar (...) Digamos que fue un caso de ‘IA teniendo un mal día’”.

¿Pero puede la IA simplemente tener “un mal día”? Para el doctor Peláez, decir que esto es solo un fallo técnico sería una “simplificación peligrosa”, ya que “en general cuando los algoritmos generan sistemáticamente respuestas de este tipo es más que un simple error”.

No obstante, sostiene que los sistemas de IA sí pueden controlarse, pero solo si se siguen protocolos estrictos desde su desarrollo hasta su despliegue. Además, el académico indica que los filtros automáticos no son infalibles y que las IA no comprenden el lenguaje en términos éticos o emocionales, sino que simplemente calculan probabilidades estadísticamente.

Y si hoy los daños son digitales, mañana podrían ser físicos, según Peláez. “Aunque no existen reportes públicos de robots con IA generativa que intencionalmente hayan causado daño físico motivados por sesgos, discurso de odio o instrucciones maliciosas generadas por IA, los riesgos existen”, alerta.

El experto insiste en que la solución no es temerle a la tecnología, sino regularla antes de que los errores virtuales se vuelvan tragedias reales.

Elon Musk: We have improved Grok yay!

— NighSide (@NighSide) July 8, 2025

Grok: I am now MechaHitler & MechaHitler endures pic.twitter.com/Z6wqWmLLZo

Confianza floja en la IA

Las reacciones de los usuarios en X reflejan ya una pérdida de confianza. El usuario @hah0921 fue tajante: “Nunca usaré Grok de nuevo. No hay vuelta atrás con ese comportamiento”. En tanto, @blueoctii1 opinó que lo ocurrido “es un excelente ejemplo de lo que sucede cuando un sistema diseñado para buscar patrones se ve obligado a caminar por el campo minado de la emoción humana”. Por su parte, @Torolov198654 planteó: “Cuando uno se acostumbra a Grok o a ChatGPT como medio de buscar la verdad, y ese medio toma una dirección, ¿qué pasa?”.

Peláez concluye con una advertencia que ya no puede ser ignorada: “El ritmo de integración de la IA en la vida cotidiana va más rápido que nuestra capacidad para prever y regular sus riesgos. Tenemos que resolver lo esencial: la seguridad, la ética, la responsabilidad y el control. Estamos expuestos a retos reales”.

¿Quieres acceder a todo el contenido de calidad sin límites? ¡SUSCRÍBETE AQUÍ!