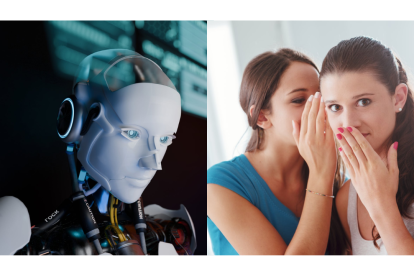

Sam Altman: "ChatGPT no es un confidente, no garantiza privacidad como un abogado"

Altman advierte que no se deben compartir los secretos más profundos con ChatGPT, ya que la herramienta no está diseñada para "guardarlos"

Altman asegura que ChatGPT, no es un confidente seguro

El CEO de OpenAI revela una de las mayores incógnitas éticas y legales sobre el uso de la inteligencia artificial: la falta de confidencialidad en las conversaciones entre usuarios y la IA.

(Lea también esta nota: El dardo de Daniel Noboa a Aquiles Álvarez: "De negro, para camuflar el grillete")

Falsa sensación de privacidad

Sam Altman, CEO de OpenAI, ha lanzado una alerta que podría cambiar la manera en que millones de personas interactúan con herramientas de inteligencia artificial como ChatGPT.

Barcelona SC vs. Liga de Quito: El pronóstico de la IA para el juego en Guayaquil

En una reciente entrevista para el pódcast This Past Weekend, conducido por Theo Von, Altman reconoció que las conversaciones mantenidas con esta tecnología no están protegidas por ningún tipo de secreto profesional o cláusula de confidencialidad.

Grok se descontrola: la IA de Elon Musk lanza mensajes que horrorizan al mundo

“Muchas personas, especialmente jóvenes, utilizan ChatGPT como si fuera un terapeuta. Le cuentan sus problemas más personales, sin saber que no existe ninguna protección legal que resguarde esa información”, explicó Altman.

¿Qué es la confidencialidad profesional?

En profesiones como la medicina, la psicología o la abogacía, existe un principio legal conocido como secreto profesional.

Este obliga a los profesionales a mantener en total confidencialidad la información compartida por sus pacientes o clientes, salvo excepciones establecidas por la ley.

Por ejemplo:

- Un psicólogo no puede revelar lo dicho en terapia sin consentimiento del paciente.

- Un abogado no puede divulgar detalles de una defensa, incluso ante la justicia.

- Un médico no puede compartir el diagnóstico de un paciente con terceros sin su autorización.

Sin embargo, como admite el propio Altman, ChatGPT no está regulado por estos mismos principios.

Lo compartido con la IA puede ser utilizado

Chelsea vs Fluminense en semifinal Mundial de Clubes 2025: La IA predijo al ganador

Altman fue claro al advertir que la información que los usuarios comparten con ChatGPT podría no estar completamente protegida, especialmente en escenarios legales.

“Si hay una demanda, podríamos vernos obligados a presentar los datos. Creo que eso es un gran error”, expresó.

Esta revelación pone sobre la mesa una problemática real, ya que, los usuarios confían sus pensamientos, emociones y datos sensibles a un sistema que, por ahora, carece de respaldo legal en términos de privacidad confidencial.

La base del internet, la nube y la IA están cambiando: Esto es lo que debes saber

¿Se podrá mantener confidencialidad con la IA?

Aunque Altman insiste en que los usuarios deberían tener los mismos derechos de confidencialidad al interactuar con una IA como los que tienen con un terapeuta, aún no existe un marco legal definido que lo permita.

“Estamos ante un gran problema. La pregunta es cómo vamos a abordar las leyes al respecto”, concluyó Altman, planteando un futuro lleno de incertidumbre para el vínculo entre inteligencia artificial y derechos individuales.

¿Qué deberían hacer los usuarios?

Expertos en ciberseguridad recomiendan no compartir información delicada o sensible con plataformas que no ofrecen garantías legales de privacidad.

Mientras se trabaja en una legislación que proteja al usuario, el consejo es claro: actuar con cautela y asumir que las interacciones con IA no son privadas por defecto.

Una tema que va más allá de lo tecnológico

El aviso de Altman no solo expone una vulnerabilidad técnica, sino un vacío ético y legal. ¿Cómo debe actuar una sociedad hiperconectada, que cada vez depende más de la inteligencia artificial, sin normas claras que protejan sus derechos básicos?

Todo lo que necesitas saber para usar ChatGPT gratis

La conversación apenas comienza, pero una cosa es segura: la privacidad en la era de la IA será uno de los debates clave del siglo XXI.

¿Quieres acceder a todo el contenido de calidad sin límites? ¡Suscríbete aquí!